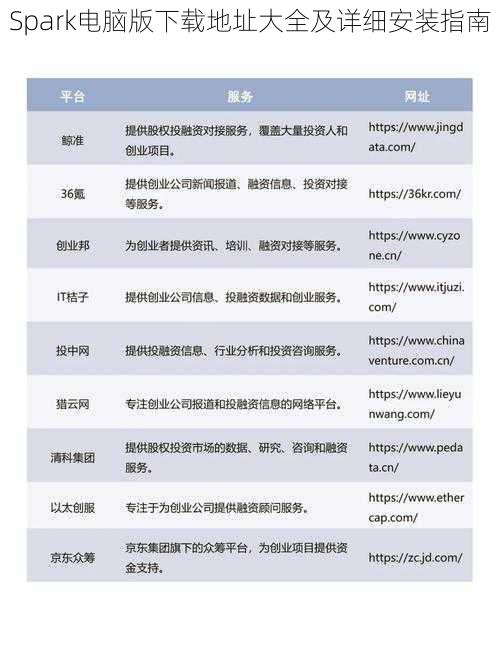

Spark电脑版下载地址大全及详细安装指南

随着大数据时代的到来,数据处理和分析变得越来越重要。Apache Spark作为一个大规模数据处理框架,受到了广泛关注和使用。本文将为您提供Spark电脑版的下载地址大全以及详细的安装指南,帮助您轻松搭建Spark环境,迎接大数据挑战。

一为什么要选择Apache Spark?

---------------

Apache Spark是一个开源的通用的数据处理引擎,能够在大数据环境下进行高效的数据处理和分析。它提供了丰富的API接口和工具,支持多种编程语言,包括ScalaPythonJava等。Spark具备内存计算快速迭代处理等优势,广泛应用于数据挖掘机器学习等领域。那么,如何在电脑上安装和使用Spark呢?接下来我们将详细介绍。

二Spark电脑版下载地址大全

-----------

在下载Spark之前,请确保您的电脑满足以下要求:

1. 操作系统:WindowsLinux或Mac OS。

2. 硬件配置:至少4GB内存,足够的硬盘空间。

3. Java环境:安装Java 8或更高版本。

以下是Spark电脑版的下载地址:

1. Apache Spark官方网站:[官方网站链接]

2. GitHub镜像站点:[GitHub链接]

3. 其他常用下载站点(如CSDN等)。

请注意,在选择下载站点时,请确保网站的可信度和安全性。避免从不明来源下载软件,以防潜在的安全风险。

三详细安装指南

--------

1. 下载Spark安装包

根据上述提供的下载地址,选择适合您操作系统的Spark安装包进行下载。

2. 安装Java环境(如果已安装请跳过)

确保您的电脑上已安装Java 8或更高版本。如果没有安装,请先下载并安装Java。

3. 解压Spark安装包

将下载的Spark安装包解压到您选择的目录。

4. 配置环境变量

在您的电脑上配置Spark相关的环境变量,包括`SPARK_HOME`和`PATH`(对于Windows用户)或`PATH`(对于Linux和Mac用户)。具体配置方法请参考操作系统相关文档。

5. 运行Spark Shell(可选)

为了验证安装是否成功,您可以运行Spark Shell(`spark-shell`)。在命令行中输入该命令后,如果看到Spark的欢迎界面,表示安装成功。

6. 使用Spark进行数据处理和分析

安装完成后,您就可以使用Spark进行数据处理和分析工作了。可以通过编写ScalaPython等语言的代码来调用Spark的API接口进行数据处理和分析。也可以利用Spark提供的工具如PySparkSpark SQL等进行数据分析。

四注意事项

------

1. 在安装过程中,请确保按照步骤进行操作,避免遗漏或错误配置。

2. 遇到时,可以参考官方文档或在线教程寻求帮助。

3. 使用Spark进行数据处理和分析时,请确保遵守相关法律法规和隐私政策。避免非法获取和使用数据。在进行机器学习等任务时,请注意数据的安全性和隐私保护。如有必要,请咨询相关专业人士或法律顾问的建议和指导。请正确使用和处理数据。希望您在掌握这些注意事项的基础上使用Spark进行数据分析和处理更加高效安全地完成任务!祝您使用愉快!如有任何疑问或建议请随时联系我们我们将竭诚为您服务!